Стриманість чат-бота робить його більш переконливим в очах користувачів.

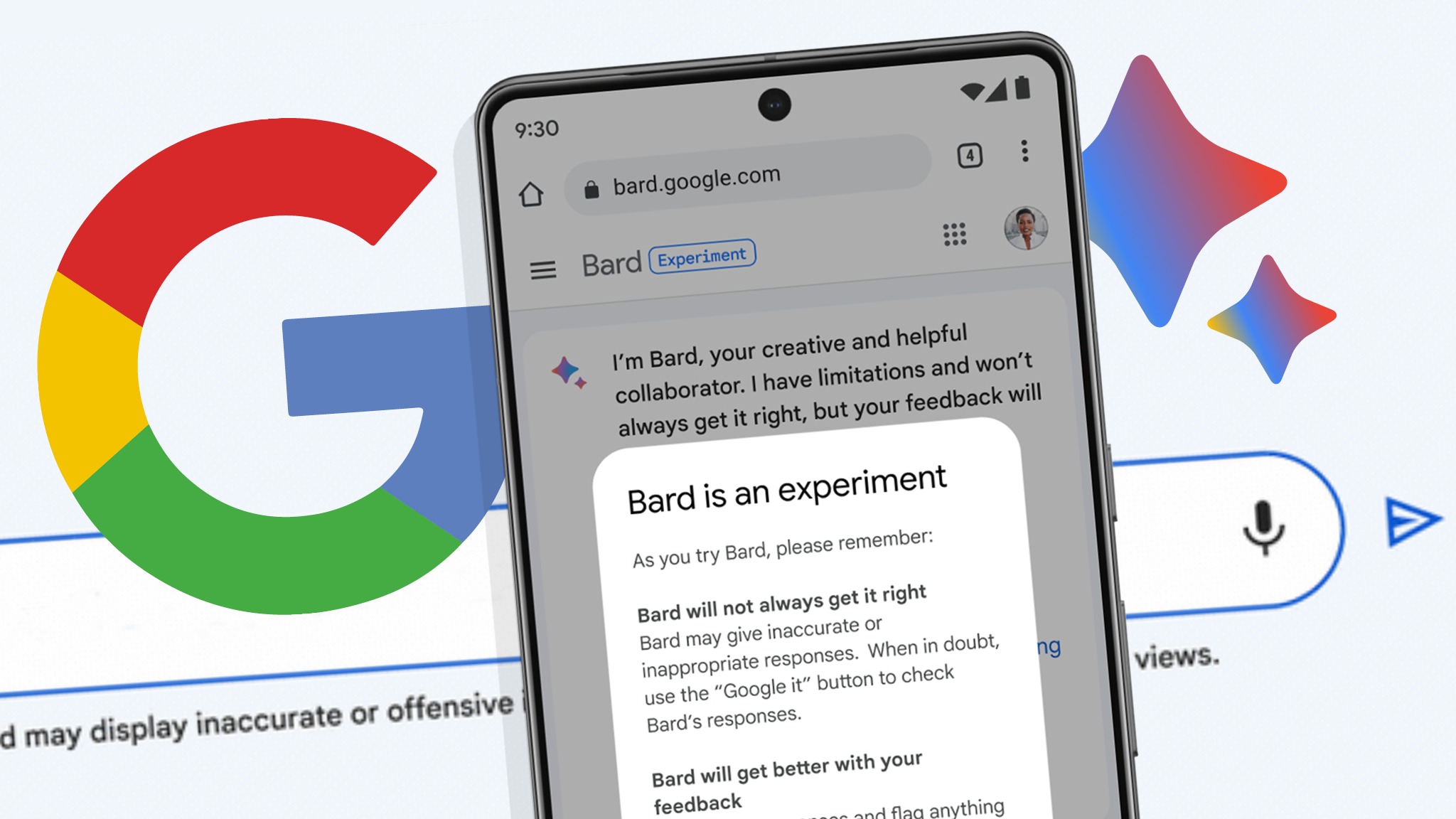

"Майкрософт" та OpenAI уже познайомили користувачів зі своїми чат-ботами. "Гугл" ще не розмістив свій продукт — Bard — у відкритий доступ, однак жителі Великобританії та США уже можуть протестувати його. Реліз чат-бота від компанії "Гугл" свідчить, що конкуренція між технологічними компаніями, які розробляють лінгвістичні моделі на базі ШІ, посилюється.

Журналістка The Wall Street Journal (WSJ) поспілкувалася з Bard і зробила доволі неочікуваний висновок: він нудний. На відміну від своїх конкурентів, Bard не такий веселий, оригінальний та нахабний. Замість відповідати на провокативні питання він зазначає, що є лінгвістичною моделлю, керованою штучним інтелектом. Цей чат-бот також не вміє писати жарти та генерувати код.

Інженери "Гугла" спеціально налаштували свій ШІ так, щоб він був більш консервативним і стриманим. В інтерв’ю WSJ Сіссі Сяо (віцепрезидентка компаніії, відповідальна за проєкт Bard) сказала, що цей чат-бот безпечний, адже в ньому є запобіжники, тобто спеціальні обмеження. Саме вони не дозволяють штучному інтелекту говорити про такі неоднозначні речі, як політика, релігія, насильство та кохання. Пані Сяо неодноразово наголошувала, що основна мета компанії — випустити чат-бот “відповідально”, адже це ранній експеримент, який може бути небезпечним.

Bard може робити те саме, що й інші відомі чат-боти. Однак журналістам WSJ його відповіді здалися плоскими та менш оригінальними. Наприклад, на прохання написати казку ChatGPT згенерував вигадану історію про кролика, який бореться зі світлячками, а Bard лише коротко переказав "Алісу в Дивокраї".

Що стосується релігії, то чат-бот майже не говорить про Бога і не розкриває своїх вірувань, але один із журналістів WSJ все-таки змусив інтелект зізнатися, що той є християнином. За словами віцепрезидентки "Гугла", компанія хоче, щоб Bard "видавав речі, які відповідають людським цінностям", додавши, що слід уникати небезпечного вмісту та упередженості у відповідях програми.

Bard, як і всі масштабні мовні моделі, навчається на величезній кількості інформації, зібраній з інтернету. Він не копіює вже колись написаний у мережі текст, а сам генерує його, використовуючи закономірності та патерни побудови речень у мові, якою він спілкується. Для відповіді він імітує те, як інші джерела пояснюють запитувані теми. Саме імітація джерел дозволяє чат-боту звучати так “по-людськи”, але через неї відповіді можуть бути сповнені неточностей та неперевіреної інформації.

За словами компанії "Гугл", штучний інтелект бере матеріали для навчання із відкритих джерел на кшталт Вікіпедії та інших онлайн-бібліотек. Сіссі Сяо наголосила, що це високоякісні матеріали, а персональні дані — наприклад, вміст електронної пошти Gmail — не включені в навчання. Однак якщо запитати Bard, на яких даних він навчався, чат-бот відповідає, що його навчали на величезному наборі даних із тексту та коду, зокрема й даних Gmail.

"Гугл" продовжує розвивати свої продукти, базовані на штучному інтелекті. Скоро Bard зможе робити посилання на використаний матеріал та генерувати код. Нещодавно компанія оголосила, що вбудує інструменти ШІ в пошуковик, Gmail та інші програмні продукти для бізнесу, чим випередила схожу заяву "Майкрософт".

Те, що ми перебуваємо у вирі розвитку штучного інтелекту, змушує нас обережно ставитися до нових технологій, керованих ШІ, — і це правильно. Оскільки компанії прагнуть додавати цю технологію буквально до всього, нам доведеться навчитися відрізняти факти від вигадок, створених ШІ.

Це не завжди легко, враховуючи постійне вдосконалення чат-ботів. А відсутність у світі однозначності щодо українського питання створює плацдарм можливостей для зловживань довкола російсько-української війни.